Trong bối cảnh trí tuệ nhân tạo (AI) đang trở thành trung tâm của mọi ngành công nghiệp, nhu cầu về sức mạnh tính toán không còn chỉ giới hạn ở các trung tâm dữ liệu khổng lồ. Các nhà khoa học dữ liệu, kỹ sư học máy và các nghệ sĩ số đang tìm kiếm những công cụ mạnh mẽ ngay trên bàn làm việc của mình. Đó chính là lúc AI Workstation (Máy trạm AI) xuất hiện. Vậy AI Workstation là gì và tại sao nó lại trở thành “vũ khí” không thể thiếu trong kỷ nguyên mới?

AI Workstation là gì?

AI Workstation là một hệ thống máy tính cá nhân hiệu năng cực cao, được thiết kế chuyên biệt để xử lý các tác vụ liên quan đến học sâu (Deep Learning), học máy (Machine Learning) và phân tích dữ liệu quy mô lớn.

Nhiều người thường nhầm lẫn AI Workstation với máy tính chơi game (Gaming PC) cao cấp. Mặc dù cả hai đều có thể sử dụng các linh kiện mạnh mẽ, nhưng sự khác biệt nằm ở độ ổn định, khả năng mở rộng và sự tối ưu hóa cho các phép tính dấu phẩy động phức tạp. Một máy trạm AI được xây dựng để chạy hết công suất 24/7 trong nhiều tuần liên tục khi huấn luyện mô hình, điều mà một chiếc PC thông thường khó lòng đáp ứng được mà không gặp lỗi hệ thống hoặc quá nhiệt.

>> Xem thêm: Máy trạm Workstation là gì?

Sự trỗi dậy của Local AI: Tại sao không phải là Cloud?

Trong vài năm qua, các dịch vụ đám mây như AWS, Google Cloud hay Azure đã thống trị mảng AI. Tuy nhiên, xu hướng đang dịch chuyển dần về Local AI (AI tại chỗ) nhờ sự ra đời của các máy trạm mạnh mẽ.

Bảo mật và quyền riêng tư tuyệt đối

Đây là lý do hàng đầu. Khi phát triển các thuật toán AI dựa trên dữ liệu khách hàng nhạy cảm hoặc bí mật thương mại, việc tải dữ liệu lên đám mây tiềm ẩn nhiều rủi ro. AI Workstation cho phép mọi quá trình tính toán diễn ra bên trong tường lửa của doanh nghiệp, giúp kiểm soát hoàn toàn dữ liệu.

Chi phí đầu tư dài hạn

Dịch vụ đám mây thường thu phí theo giờ sử dụng GPU. Nếu bạn là một nhà nghiên cứu cần thực hiện hàng trăm thí nghiệm mỗi tháng, hóa đơn đám mây sẽ trở thành một gánh nặng tài chính khổng lồ. Việc đầu tư một chiếc AI Workstation có chi phí ban đầu (CapEx) cao, nhưng sau khoảng 6-12 tháng sử dụng liên tục, chi phí này sẽ trở nên rẻ hơn rất nhiều so với việc thuê cloud.

Độ trễ và hiệu suất làm việc

Làm việc trên máy trạm cục bộ giúp loại bỏ độ trễ của đường truyền internet. Các thao tác tinh chỉnh mã nguồn, xem trước kết quả hình ảnh từ các mô hình tạo ảnh (Generative AI) diễn ra ngay lập tức, giúp tăng tốc quy trình thử nghiệm và sai số (R&D).

Giải phẫu cấu hình của một AI Workstation tiêu chuẩn

Để gánh vác được các mô hình AI hàng tỷ tham số, các thành phần phần cứng bên trong máy trạm cần được tuyển chọn khắt khe.

GPU – Trái tim của mọi phép tính

Trong AI, GPU quan trọng hơn CPU rất nhiều. GPU chịu trách nhiệm thực hiện hàng triệu phép tính ma trận song song. Khi chọn GPU cho AI Workstation, yếu tố quan trọng nhất không phải là xung nhịp mà là VRAM (Video RAM).

VRAM quyết định kích thước của mô hình AI mà bạn có thể nạp vào máy. Nếu VRAM quá nhỏ, bạn sẽ gặp lỗi “Out of Memory” ngay lập tức. Các máy trạm AI thường sử dụng GPU có từ 24GB VRAM trở lên (như RTX 4090) hoặc các dòng chuyên dụng như NVIDIA RTX 6000 Ada với 48GB VRAM.

CPU – Người điều phối đa tài

CPU đóng vai trò quản lý việc nạp dữ liệu từ ổ cứng vào GPU và thực hiện các bước tiền xử lý dữ liệu (Data Preprocessing). Một chiếc CPU có nhiều nhân (như AMD Threadripper hoặc Intel Xeon) sẽ giúp việc xử lý các tập dữ liệu thô nhanh chóng hơn, giúp GPU không phải rơi vào trạng thái “chờ” dữ liệu.

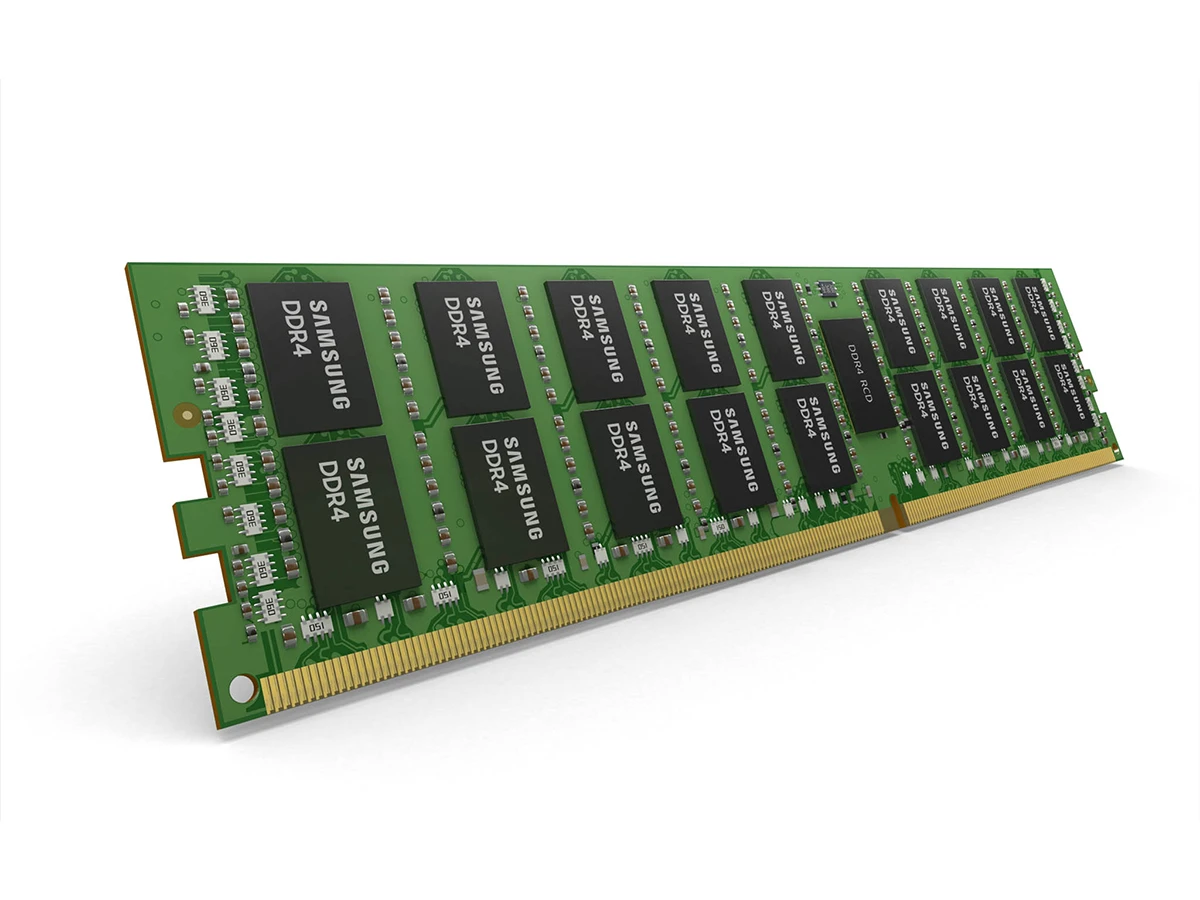

Bộ nhớ RAM hệ thống

Một quy tắc ngầm trong giới xây dựng máy trạm AI là dung lượng RAM hệ thống nên gấp ít nhất 2 lần tổng dung lượng VRAM của tất cả các GPU cộng lại. Nếu hệ thống của bạn có 2 chiếc card 24GB (tổng 48GB VRAM), bạn nên có ít nhất 96GB hoặc 128GB RAM DDR5 để đảm bảo sự ổn định khi xử lý các tập dữ liệu lớn trong bộ nhớ.

Lưu trữ tốc độ cao

Sử dụng ổ cứng SSD NVMe PCIe Gen4 hoặc Gen5 là bắt buộc. Khi huấn luyện AI, máy tính cần đọc hàng triệu tệp tin nhỏ (hình ảnh, văn bản) từ ổ cứng. Tốc độ đọc ngẫu nhiên (Random Read) cao sẽ giúp giảm thời gian huấn luyện mô hình một cách đáng kể.

Các dòng GPU phổ biến cho máy trạm AI năm 2026

Thị trường hiện nay chia thành hai phân khúc chính cho AI Workstation:

Phân khúc phổ thông và chuyên gia (Consumer/Prosumer)

- NVIDIA GeForce RTX 4090: Đây là “ông vua” trong tầm giá phổ thông với 24GB VRAM và nhân Tensor thế hệ mới. Nó cực kỳ phổ biến trong giới nghiên cứu nhờ hiệu năng trên giá thành (P/P) tuyệt vời.

- NVIDIA GeForce RTX 5090 (Dự kiến): Với những thông tin rò rỉ về băng thông bộ nhớ vượt trội, đây sẽ là mục tiêu săn đón tiếp theo của các kỹ sư AI.

Phân khúc doanh nghiệp và nghiên cứu chuyên sâu (Enterprise)

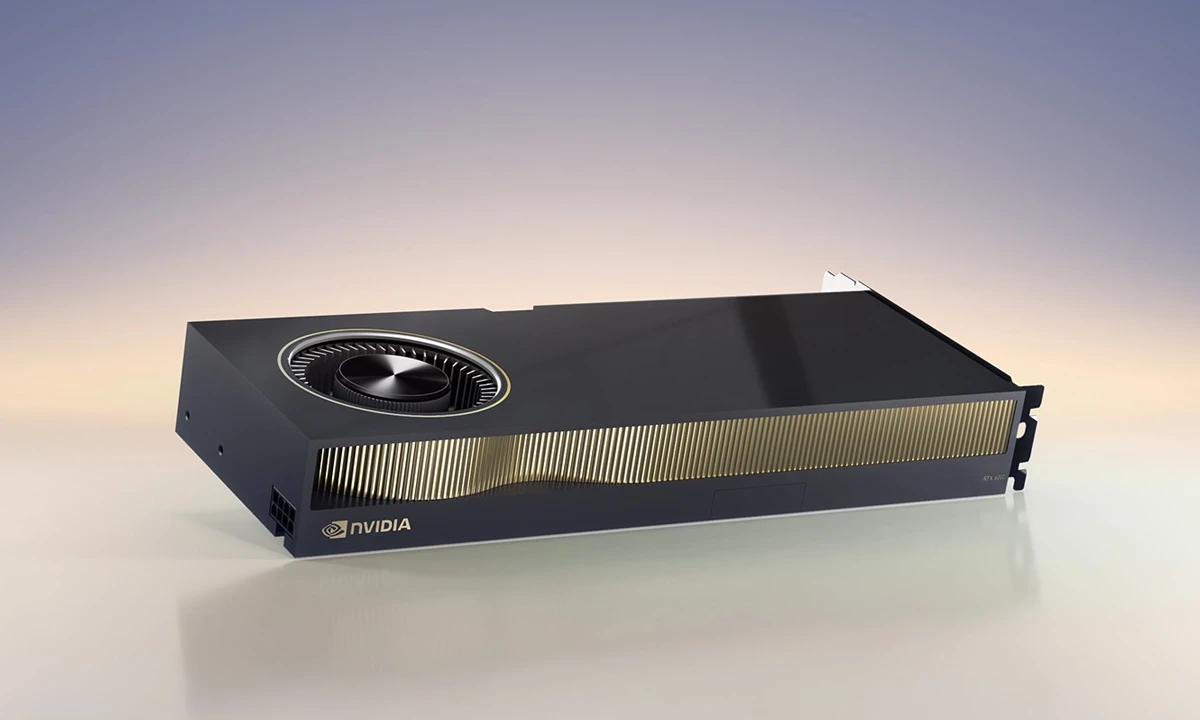

- NVIDIA RTX 6000 Ada Generation: Sở hữu 48GB VRAM và khả năng ghép nối nhiều card thông qua hệ thống tản nhiệt lồng sóc (Blower fan) tối ưu cho không gian hẹp.

- NVIDIA RTX A-series: Dòng card có độ bền cực cao, hỗ trợ bộ nhớ ECC giúp phát hiện và sửa lỗi dữ liệu, cực kỳ quan trọng cho các phép tính khoa học cần độ chính xác tuyệt đối.

Hệ điều hành và Phần mềm: Nơi sức mạnh được khai phá

Một chiếc AI Workstation mạnh mẽ sẽ trở nên vô dụng nếu không được cài đặt đúng phần mềm.

Linux hay Windows?

Phần lớn cộng đồng AI sử dụng Linux (đặc biệt là Ubuntu) vì khả năng quản lý tài nguyên tốt và sự hỗ trợ tận gốc từ các thư viện của NVIDIA. Tuy nhiên, với sự phát triển của WSL2 (Windows Subsystem for Linux), người dùng hiện nay có thể chạy các môi trường Linux ngay trên Windows với hiệu năng gần như tương đương, mang lại sự tiện lợi cho cả công việc văn phòng lẫn nghiên cứu AI.

Các công cụ quản lý môi trường

- Docker: Cho phép đóng gói toàn bộ môi trường AI (thư viện, driver, code) vào các container để có thể di chuyển giữa các máy tính khác nhau mà không lo lỗi xung đột.

- Anaconda/Miniconda: Công cụ quản lý các phiên bản Python và thư viện (PyTorch, TensorFlow) một cách khoa học.

- NVIDIA CUDA Toolkit: Thư viện nền tảng cho phép phần mềm tận dụng sức mạnh của nhân Tensor bên trong GPU.

Ứng dụng thực tế của AI Workstation

AI Workstation không chỉ dành cho các “mọt sách” công nghệ, nó đang thay đổi cách chúng ta làm việc:

Huấn luyện và tinh chỉnh mô hình ngôn ngữ (LLM Fine-tuning)

Bạn muốn có một phiên bản GPT riêng cho công ty mình dựa trên dữ liệu nội bộ? Một chiếc máy trạm với 2-4 GPU RTX 4090 có thể thực hiện việc tinh chỉnh (Fine-tuning) các mô hình như Llama 3 hoặc Mistral trong thời gian ngắn, giúp tạo ra một trợ lý AI thông minh và bảo mật.

Thị giác máy tính (Computer Vision)

Từ việc nhận diện khuôn mặt, phát hiện lỗi sản phẩm trong nhà máy đến phân tích hình ảnh y tế (X-quang, MRI). AI Workstation xử lý hàng ngàn khung hình mỗi giây để huấn luyện các thuật toán nhận diện vật thể với độ chính xác cao.

Sáng tạo nghệ thuật và Generative AI

Các nghệ sĩ sử dụng Stable Diffusion hoặc Midjourney (phiên bản chạy cục bộ) cần AI Workstation để tạo ra các hình ảnh, video chất lượng cao mà không phải chờ đợi hàng đợi trên máy chủ công cộng. Khả năng “Train” các LoRA (mô hình học phong cách nghệ thuật) cá nhân cũng yêu cầu một bộ nhớ VRAM lớn.

Thách thức: Nhiệt độ, Điện năng và Tiếng ồn

Sức mạnh càng lớn, trách nhiệm càng cao – và nhiệt lượng cũng vậy.

- Điện năng: Một hệ thống chạy 4 GPU RTX 4090 có thể ngốn tới 2000W điện. Bạn cần một bộ nguồn (PSU) đạt chuẩn 80 Plus Platinum trở lên và có thể là một hệ thống điện ổn áp riêng để tránh chập cháy.

- Tản nhiệt: Đây là yếu tố sống còn. Các máy trạm AI thường sử dụng tản nhiệt nước (Custom Liquid Cooling) hoặc các dòng card có thiết kế tản nhiệt lồng sóc để đẩy hơi nóng trực tiếp ra ngoài thùng máy. Nếu không tản nhiệt tốt, GPU sẽ tự giảm xung nhịp (Thermal Throttling), khiến hiệu suất sụt giảm nghiêm trọng.

- Tiếng ồn: Khi quạt GPU quay ở tốc độ cao nhất, tiếng ồn có thể tương đương với một chiếc máy hút bụi. Do đó, việc đặt máy trạm trong một phòng riêng biệt hoặc sử dụng các thùng máy cách âm là điều cần cân nhắc.

Hướng dẫn chọn mua AI Workstation cho người mới

Nếu bạn đang có ý định đầu tư, hãy cân nhắc các lộ trình sau:

- Mức bắt đầu (Starter): 1x RTX 4090 (24GB VRAM), CPU 12-16 nhân, 64GB RAM. Phù hợp cho việc học tập, nghiên cứu và làm các dự án AI quy mô vừa.

- Mức chuyên nghiệp (Pro): 2x RTX 4090 hoặc 1x RTX 6000 Ada, CPU 32 nhân, 128GB RAM. Phù hợp cho các doanh nghiệp nhỏ muốn tự phát triển mô hình riêng.

- Mức cao cấp (High-end): 4x RTX 6000 Ada, hệ thống tản nhiệt nước, CPU Threadripper 64 nhân, 256GB RAM trở lên. Đây là công cụ dành cho các phòng Lab nghiên cứu chuyên sâu.

Tương lai của AI Workstation: Khi ánh sáng thay thế dòng điện

Trong tương lai gần, chúng ta sẽ thấy sự xuất hiện của các kết nối quang học (Optical Computing) ngay trong máy trạm, giúp tốc độ truyền dữ liệu giữa CPU và GPU đạt mức ánh sáng. Các chip AI sẽ không chỉ làm từ Silicon mà có thể tích hợp các bộ vi xử lý lượng tử thu nhỏ. AI Workstation sẽ không còn là một chiếc thùng máy cồng kềnh mà có thể thu gọn lại như một chiếc máy tính xách tay nhưng sở hữu sức mạnh của cả một trung tâm dữ liệu hiện nay.

Lời kết

AI Workstation không chỉ là một công cụ, nó là sự tự do. Tự do trong việc sáng tạo mà không lo về chi phí thuê mây, tự do trong việc bảo vệ dữ liệu và tự do trong việc thử nghiệm những ý tưởng điên rồ nhất của trí tuệ nhân tạo. Dù bạn là một sinh viên mới bắt đầu hay một chuyên gia dày dạn kinh nghiệm, việc sở hữu và làm chủ một chiếc máy trạm AI sẽ là bước ngoặt giúp bạn chinh phục đỉnh cao trong kỷ nguyên số.