Nếu như trí tuệ nhân tạo (AI) được coi là “dòng điện mới” của thế kỷ 21, thì AI Server chính là những nhà máy phát điện khổng lồ cung cấp năng lượng cho toàn bộ hệ sinh thái đó. Từ việc huấn luyện những siêu mô hình như GPT-4 cho đến việc xử lý hàng tỷ yêu cầu tìm kiếm bằng hình ảnh mỗi giây, tất cả đều dựa trên sức mạnh của một loại máy chủ đặc biệt: AI Server.

AI Server là gì?

AI Server (Máy chủ AI) là một loại máy chủ chuyên dụng được thiết kế và tối ưu hóa để xử lý các khối lượng công việc liên quan đến trí tuệ nhân tạo, học máy (machine learning) và học sâu (deep learning).

Về cơ bản, một máy chủ truyền thống thường tập trung vào khả năng xử lý đa nhiệm, quản lý cơ sở dữ liệu hoặc lưu trữ tệp tin thông qua CPU. Ngược lại, AI Server tập trung vào khả năng tính toán song song ở quy mô cực lớn. Nó không chỉ đơn thuần là cắm thêm một vài chiếc card đồ họa vào máy chủ, mà là một sự thay đổi toàn diện về mặt kiến trúc, từ cách dữ liệu di chuyển giữa các bộ phận cho đến cách tản nhiệt cho những linh kiện tỏa nhiệt lượng khủng khiếp.

Tại sao máy chủ thông thường không thể gánh vác các tác vụ AI?

Sự khác biệt nằm ở bản chất của phép toán.

- Máy chủ thông thường: Sử dụng CPU (Central Processing Unit) để thực hiện các phép tính tuần tự phức tạp. CPU giống như một giáo sư toán học có thể giải được mọi bài toán nhưng mỗi lần chỉ giải được một bài.

- AI Server: Sử dụng GPU (Graphics Processing Unit) hoặc các chip tăng tốc chuyên dụng để thực hiện hàng triệu phép tính ma trận đơn giản cùng một lúc. GPU giống như hàng ngàn học sinh tiểu học cùng làm các phép tính nhân đơn giản trên một bảng lớn.

Các mô hình AI hiện đại bao gồm hàng tỷ tham số. Để huấn luyện chúng, hệ thống cần thực hiện hàng triệu tỷ phép tính toán học mỗi giây. Một máy chủ thông thường nếu chạy tác vụ này có thể mất hàng trăm năm, trong khi một cụm AI Server có thể hoàn thành trong vài tuần hoặc vài ngày.

Kiến trúc phần cứng của một AI Server tiêu chuẩn

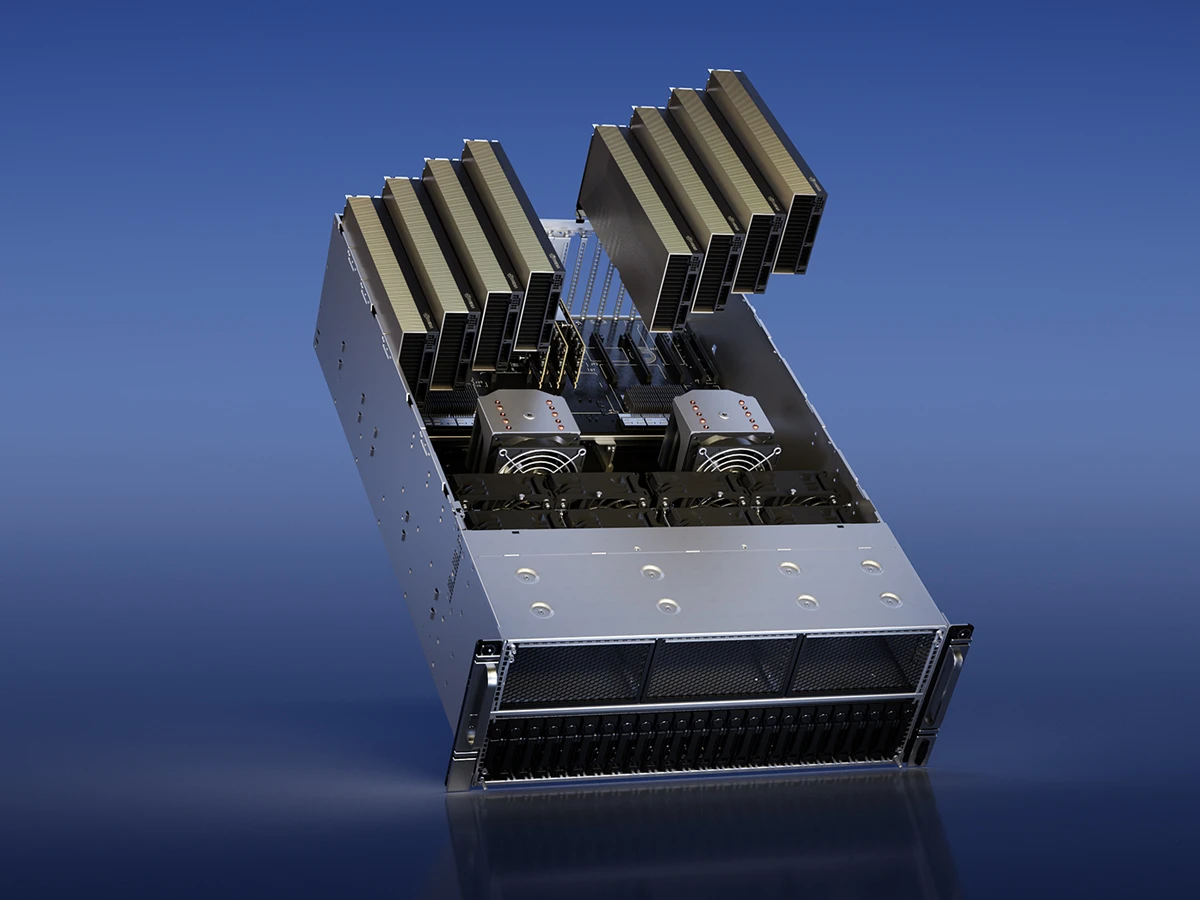

Một chiếc AI Server hiện đại (ví dụ như NVIDIA DGX H100) là một kỳ quan về mặt kỹ thuật. Dưới đây là những thành phần cốt lõi tạo nên sức mạnh của nó.

Bộ xử lý tăng tốc (Accelerators) – Linh hồn của hệ thống

Đây là thành phần quan trọng nhất. Phổ biến nhất hiện nay là các GPU cao cấp như NVIDIA H100, H200 hoặc dòng Blackwell mới nhất. Ngoài ra, chúng ta còn thấy sự xuất hiện của các loại chip chuyên dụng khác:

- TPU (Tensor Processing Unit): Do Google thiết kế dành riêng cho các tác vụ Tensor.

- NPU (Neural Processing Unit): Tập trung vào việc mô phỏng các mạng thần kinh nhân tạo.

- ASIC: Các loại chip tùy chỉnh cho một thuật toán AI cụ thể.

CPU đóng vai trò điều phối

Mặc dù GPU thực hiện các phép tính chính, nhưng AI Server vẫn cần những chiếc CPU mạnh mẽ (như dòng Intel Xeon hoặc AMD EPYC) để quản lý luồng dữ liệu, điều phối các tác vụ vào/ra (I/O) và nạp dữ liệu từ ổ cứng vào bộ nhớ GPU.

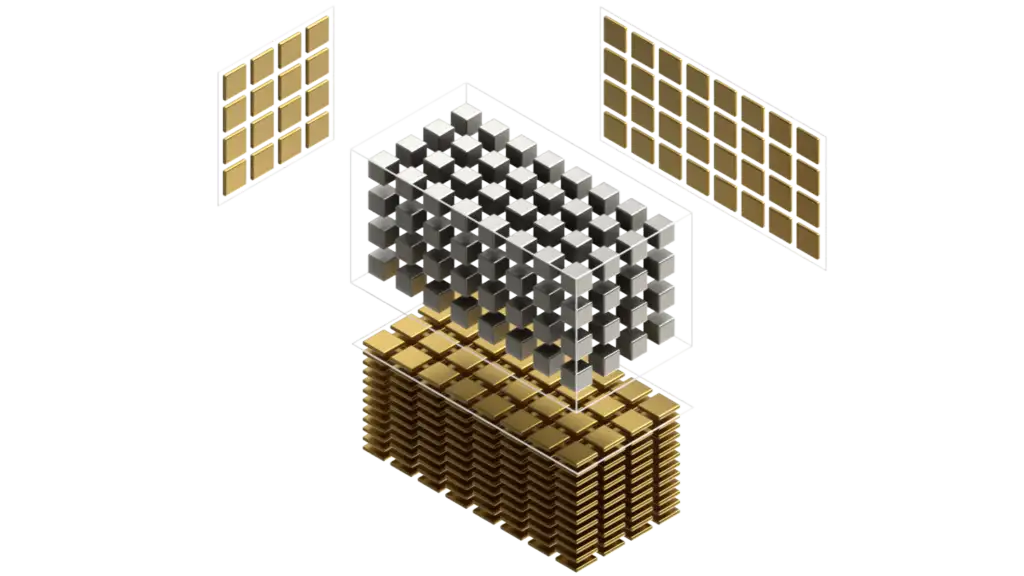

HBM – Bộ nhớ băng thông cao

Trong AI, dữ liệu cần được nạp vào bộ xử lý với tốc độ cực nhanh. RAM DDR5 thông thường là không đủ. AI Server sử dụng HBM (High Bandwidth Memory). Đây là loại bộ nhớ được xếp chồng lên nhau theo chiều dọc và đặt trực tiếp trên cùng một đế chip với GPU. Điều này giúp rút ngắn khoảng cách di chuyển của dữ liệu, giảm độ trễ và tăng băng thông lên mức hàng Terabyte mỗi giây.

Hệ thống lưu trữ tốc độ cao

Các tập dữ liệu huấn luyện AI (Dataset) thường có kích thước từ vài Terabyte đến hàng Petabyte. AI Server yêu cầu các ổ cứng NVMe SSD với giao thức PCIe Gen5 để đảm bảo dữ liệu luôn sẵn sàng cho GPU xử lý, tránh tình trạng “GPU chờ dữ liệu” gây lãng phí tài nguyên.

Tensor Core và các công nghệ kết nối siêu tốc

Đi sâu hơn vào mặt kỹ thuật, AI Server sở hữu những công nghệ mà máy chủ thường không có.

Tensor Core là gì?

Đây là các nhân xử lý chuyên biệt nằm bên trong GPU NVIDIA. Khác với các nhân CUDA thông thường, Tensor Core được thiết kế để thực hiện các phép tính nhân ma trận 4×4 chỉ trong một chu kỳ xung nhịp. Đây chính là “vũ khí bí mật” giúp các dòng GPU của NVIDIA thống trị mảng huấn luyện mô hình ngôn ngữ lớn (LLM).

>> Xem chi tiết: Tensor Core Là Gì? Giải Mã “Vũ Khí” Tăng Tốc AI Gấp 100 Lần Của NVIDIA

NVLink và NVSwitch: Phá vỡ giới hạn PCIe

Khi bạn kết nối 8 chiếc GPU vào một máy chủ, việc chúng giao tiếp với nhau qua khe cắm PCIe truyền thống sẽ tạo ra hiện tượng nghẽn cổ chai. NVIDIA đã phát triển công nghệ NVLink, cho phép các GPU truyền dữ liệu trực tiếp cho nhau với tốc độ nhanh gấp nhiều lần so với PCIe. NVSwitch đóng vai trò như một bộ định tuyến khổng lồ, kết nối tất cả GPU trong một hệ thống hoặc giữa nhiều máy chủ với nhau thành một “siêu GPU” duy nhất.

Phân loại AI Server theo mục đích sử dụng

Không phải mọi AI Server đều giống nhau. Tùy vào giai đoạn phát triển của mô hình AI mà cấu hình máy chủ sẽ thay đổi.

Server huấn luyện (AI Training Server)

Đây là những “con quái vật” về cấu hình. Mục tiêu là nạp hàng tỷ dữ liệu vào mô hình để nó học được kiến thức.

- Đặc điểm: Cần số lượng GPU lớn (thường là 8 GPU mỗi node), bộ nhớ HBM cực lớn và khả năng kết nối liên kết máy chủ (Interconnect) cực mạnh.

- Chi phí: Rất đắt đỏ, từ vài trăm ngàn đến hàng triệu USD mỗi hệ thống.

Server suy luận (AI Inference Server)

Sau khi mô hình đã được huấn luyện, nó sẽ được triển khai để trả lời người dùng (suy luận). Ví dụ, khi bạn hỏi ChatGPT một câu, một Inference Server đang xử lý yêu cầu đó.

- Đặc điểm: Tập trung vào độ trễ thấp (Latency) và hiệu quả sử dụng điện năng. Nó không cần 8 chiếc H100 mạnh nhất, đôi khi chỉ cần các dòng GPU tầm trung hoặc các chip chuyên dụng cho suy luận như NVIDIA L40S hoặc T4.

- Mục tiêu: Phục vụ hàng triệu người dùng cùng lúc với chi phí vận hành rẻ nhất.

Edge AI Server

Thay vì đặt trong các trung tâm dữ liệu lớn, các máy chủ này được đặt gần nơi phát sinh dữ liệu (như trong nhà máy, bệnh viện hoặc trạm viễn thông 5G).

- Đặc điểm: Thiết kế nhỏ gọn, chịu được môi trường khắc nghiệt và thường tập trung vào việc xử lý dữ liệu thời gian thực từ camera hoặc cảm biến.

Cuộc đua phần cứng: Những cái tên thống trị

NVIDIA: Vị vua không ngai

Hiện tại, NVIDIA nắm giữ hơn 80% thị phần AI Server toàn cầu. Sức mạnh của họ không chỉ nằm ở chip H100 hay Blackwell, mà còn ở nền tảng phần mềm CUDA. Hầu như mọi thư viện AI phổ biến nhất hiện nay đều được viết tối ưu cho kiến trúc của NVIDIA.

AMD: Kẻ thách thức mạnh mẽ

Với dòng chip Instinct MI300X, AMD đang chứng minh rằng họ có thể cung cấp lượng bộ nhớ HBM lớn hơn và băng thông rộng hơn so với các đối thủ. Đây là một sự lựa chọn hấp dẫn cho các doanh nghiệp muốn thoát khỏi sự phụ thuộc vào NVIDIA.

Xu hướng tự làm chip của Big Tech

Các ông lớn như Google, Meta, Amazon và Microsoft đang dần tự thiết kế chip AI riêng để tối ưu hóa chi phí. Ví dụ, Google đã thành công rực rỡ với dòng TPU, giúp họ vận hành các dịch vụ tìm kiếm và dịch thuật AI một cách hiệu quả nhất.

Hạ tầng xung quanh AI Server: Điện năng và Tản nhiệt

Một chiếc AI Server tiêu chuẩn có thể tiêu thụ từ 10kW đến 15kW điện năng, tương đương với mức tiêu thụ của cả một hộ gia đình trong một tháng nhưng chỉ diễn ra trong một không gian bằng chiếc tủ lạnh nhỏ. Điều này đặt ra hai thách thức lớn.

Năng lượng điện (Power)

Các trung tâm dữ liệu AI hiện nay đang phải thiết kế lại toàn bộ hệ thống cấp điện. Các thanh dẫn điện (Busbar) phải chịu được cường độ dòng điện cực lớn để cung cấp cho hàng ngàn máy chủ chạy cùng lúc.

Tản nhiệt chất lỏng (Liquid Cooling)

Tản nhiệt khí truyền thống đã chạm đến giới hạn. Với các dòng chip mới như Blackwell tỏa nhiệt lên tới 1000W mỗi chip, tản nhiệt chất lỏng là bắt buộc. Nước hoặc các dung dịch làm mát đặc biệt sẽ được dẫn qua các tấm block áp trực tiếp vào chip để lấy nhiệt đi một cách hiệu quả nhất. Đây là xu hướng không thể đảo ngược của các AI Server từ năm 2026 trở đi.

Lợi ích khi doanh nghiệp sở hữu AI Server riêng

Dù các dịch vụ đám mây (Cloud AI) rất tiện lợi, nhiều doanh nghiệp vẫn chọn đầu tư AI Server tại chỗ (On-premise):

- Bảo mật dữ liệu: Các dữ liệu nhạy cảm về khách hàng, bằng sáng chế không bao giờ được phép ra khỏi hệ thống nội bộ.

- Chi phí dài hạn: Nếu chạy tác vụ AI liên tục 24/7, việc sở hữu máy chủ riêng sẽ rẻ hơn đáng kể so với việc thuê theo giờ trên mây.

- Kiểm soát hoàn toàn: Doanh nghiệp có thể tùy chỉnh sâu vào phần cứng và phần mềm để đạt hiệu suất cao nhất cho thuật toán đặc thù của mình.

Hướng dẫn cơ bản khi lựa chọn AI Server cho dự án

Khi bắt đầu xây dựng hệ thống, bạn cần trả lời các câu hỏi sau:

- Dữ liệu của bạn lớn đến mức nào?: Điều này quyết định dung lượng RAM và bộ nhớ GPU (VRAM) cần thiết.

- Bạn đang Training hay Inference?: Nếu là Training, đừng tiết kiệm tiền cho kết nối NVLink.

- Hạ tầng phòng máy hiện có chịu tải được không?: Hãy kiểm tra công suất điện và hệ thống làm mát trước khi đặt mua một node GPU.

- Ngân sách: Đôi khi việc bắt đầu với các dòng GPU cũ hơn hoặc thuê máy chủ ảo là bước đệm tốt trước khi đầu tư hàng tỷ đồng vào phần cứng mới nhất.

Thách thức về đạo đức và môi trường

Sự bùng nổ của AI Server mang lại những lo ngại về dấu chân carbon. Một câu hỏi gửi cho AI tiêu thụ lượng điện gấp nhiều lần so với một lần tìm kiếm Google thông thường. Các nhà sản xuất máy chủ đang nỗ lực đạt được chỉ số PUE (Power Usage Effectiveness) gần mức 1.0 bằng cách sử dụng năng lượng tái tạo và công nghệ làm mát tiên tiến.

Tương lai của AI Server: Kỷ nguyên của sự tích hợp

Chúng ta đang tiến tới một tương lai nơi AI Server không còn là những khối thép rời rạc. Kiến trúc Blackwell của NVIDIA hay các hệ thống Rack-scale của siêu máy tính đang biến toàn bộ một dãy tủ rack thành một chiếc máy tính khổng lồ duy nhất.

Công nghệ quang học (Optical Interconnect) sẽ sớm thay thế các dây đồng truyền thống để truyền dữ liệu giữa các chip bằng ánh sáng, giúp tăng tốc độ lên hàng chục lần và giảm thiểu nhiệt lượng tỏa ra. AI Server sẽ ngày càng trở nên thông minh hơn, tiết kiệm điện hơn và đóng vai trò như một bộ não nhân tạo trung tâm cho mọi hoạt động của con người.

Lời kết

AI Server không còn là một khái niệm xa lạ dành cho các nhà khoa học máy tính, nó đã trở thành hạ tầng thiết yếu của nền kinh tế số. Hiểu về AI Server là hiểu về cách mà thế giới tương lai vận hành. Cho dù bạn là một chủ doanh nghiệp đang tìm cách tối ưu hóa quy trình bằng AI, hay một kỹ sư đang xây dựng những ứng dụng của tương lai, việc nắm bắt sức mạnh từ những chiếc máy chủ này chính là chìa khóa để dẫn đầu trong cuộc đua trí tuệ nhân tạo.